MiniMax M1: "the World's First Open-Source, Large-Scale, Hybrid-Attention Reasoning Model"

Una nuova azienda cinese, molto interessante è MiniMax, che nel 2024 è stata finanziata anche da Alibaba (azienda proprietaria della famiglia di modelli Qwen AI) e da Tencent (azienda proprietaria della famiglia di modelli Hunyuan).

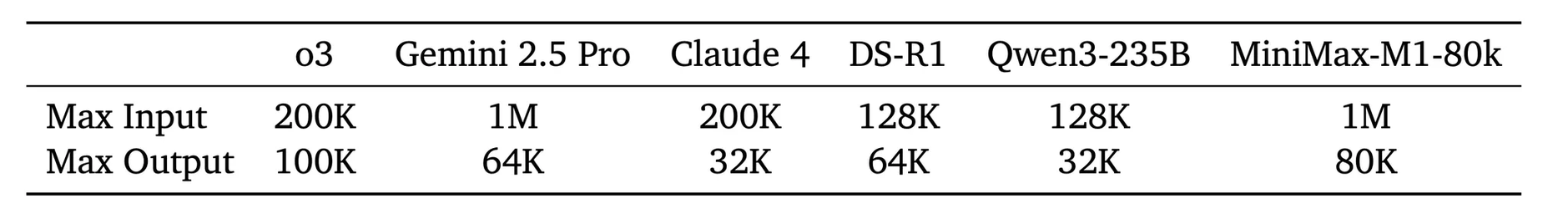

In particolare il modello MiniMax-M1 (oltre che essere open-source, licenza Apache 2.0) viene presentato come il numero uno al mondo della tipologia open-weight su larga scala di tipo "hybrid-attention reasoning model". Tecnicamente è un MoE da 456 miliardi di parametri totali, con 45,9 miliardi di parametri attivi per token. L'aspetto più interessante di questo modello è il contesto da 1 milione di token (8 volte maggiore rispetto a quello di deepseek-r1). Il meccanismo "lightning attention" consente gestione efficiente anche con un contesto lungo (da quanto dichiarato, il 25% più efficiente rispetto al già ottimo deepseek-r1). Quindi MiniMax-M1 è particolarmente adatto per l'analisi di task lunghi e complessi, con un'ottima gestione delle risorse.

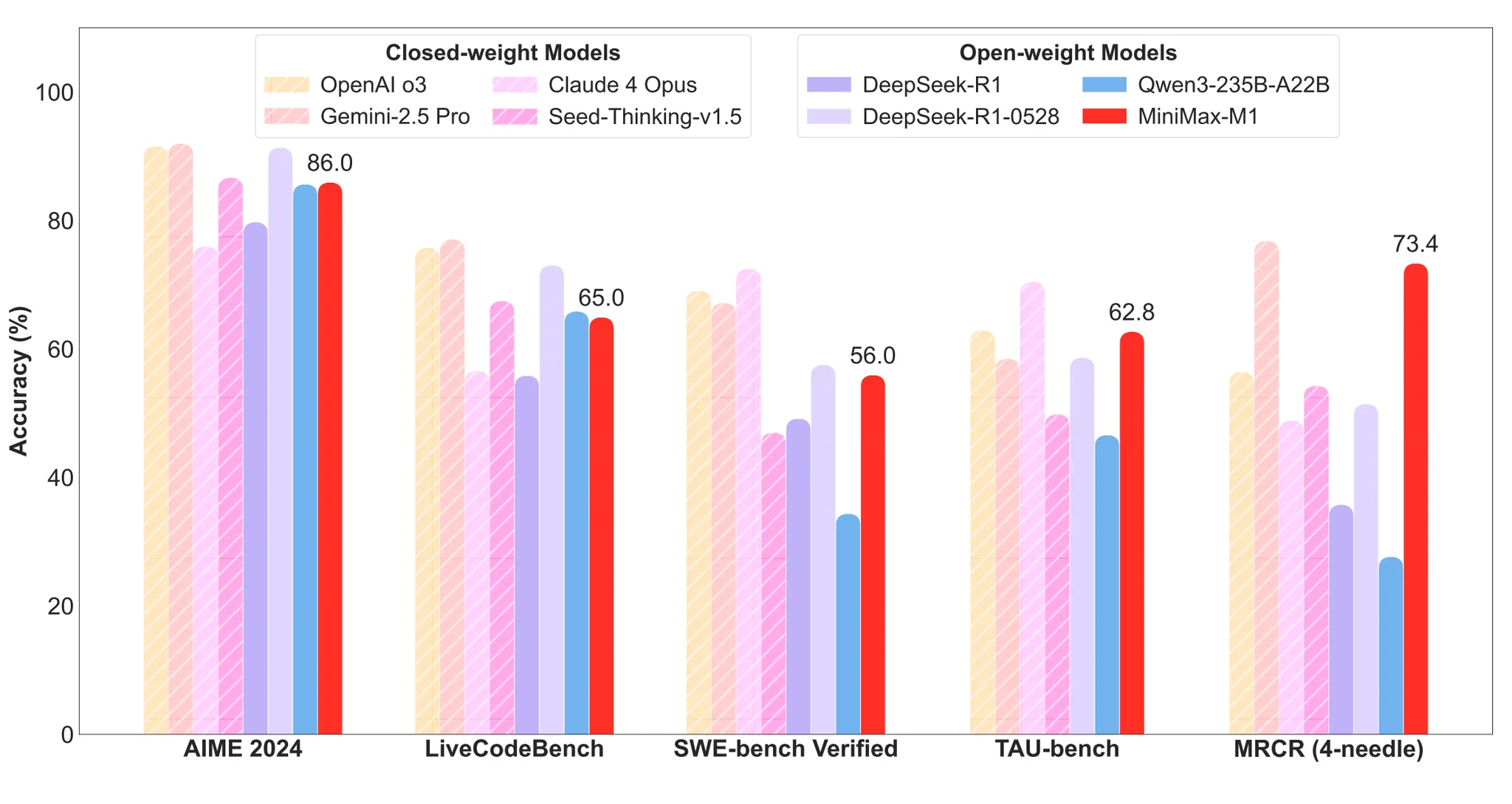

La presentazione di MiniMax-M1, con tutte le informazioni e risultati dei benchmark, sul sito ufficiale minimax.io, da cui sono tratte le immagini che seguono, per avere un'idea dei confronti fra modelli. Altre info anche riportate sulla relativa pagina GitHub.

Nota aggiuntiva: la raccomandazione ufficiale fornita dal produttore è temperature=1.0, top_p=0.95. Quindi un compromesso che inizialmente allarga le possibilità di creatività grazie a temperature (è possibile che vengano generati dal modello anche token meno probabili), ma la successiva fase con top_p limita la scelta al "nucleo" statisticamente più probabile (un controllo quindi per evitare scelte troppo improbabili o assurde).

L'azienda MiniMax ha rilasciato anche altri modelli multimodali, come Hailuo-02, Speech-02, Music-01.

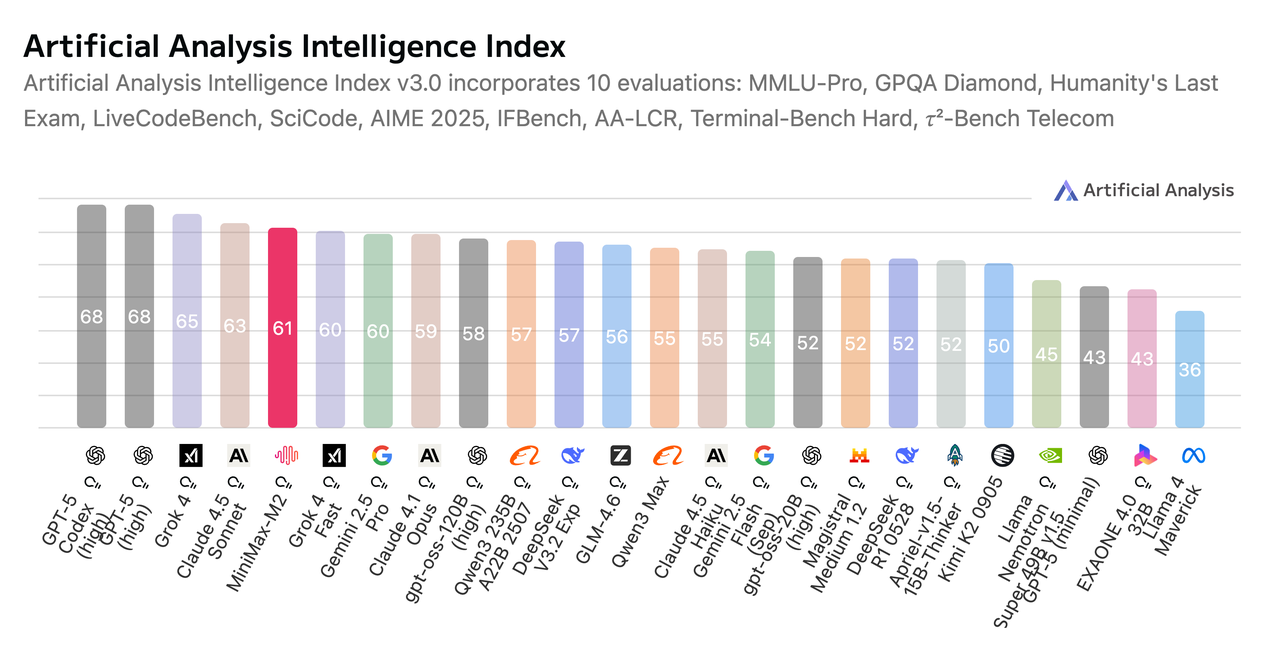

A fine ottobre 2025 viene rilasciato MiniMax-M2, ancora più compatto ed efficiente: MoE con 230 miliardi di parametri di cui 10 miliardi attivi (M1 invece 456 miliardi di parametri di cui 49,5 attivi); lunghezza del contesto 128k token. Performance e risultati nei benchmark ancora migliori, da GitHub l'immagine che segue e dal sito ufficiale minimax.io la successiva, che mostra un ottimo risultato complessivo nella valutazione aggregata di più test, fra i top al mondo.