A livello di ricerca, ho pensato a questo caso interessante. I Core Web Vitals sappiamo essere un importante fattore di ranking e misurano (leggete con attenzione!) l'esperienza utente reale relativa a prestazioni di caricamento, interattività e stabilità visiva della pagina.

La cosiddetta SEO Black Hat oggi è lontana anni luce da come veniva applicata all'inizio, ovvero cercare di "fregare l'algoritmo" agendo sul proprio sito web; no, oggi è tutto più sofisticato ed evoluto, chi ne fa uso agisce spesso... Contro i competitor (tralasciamo la questione legalità).

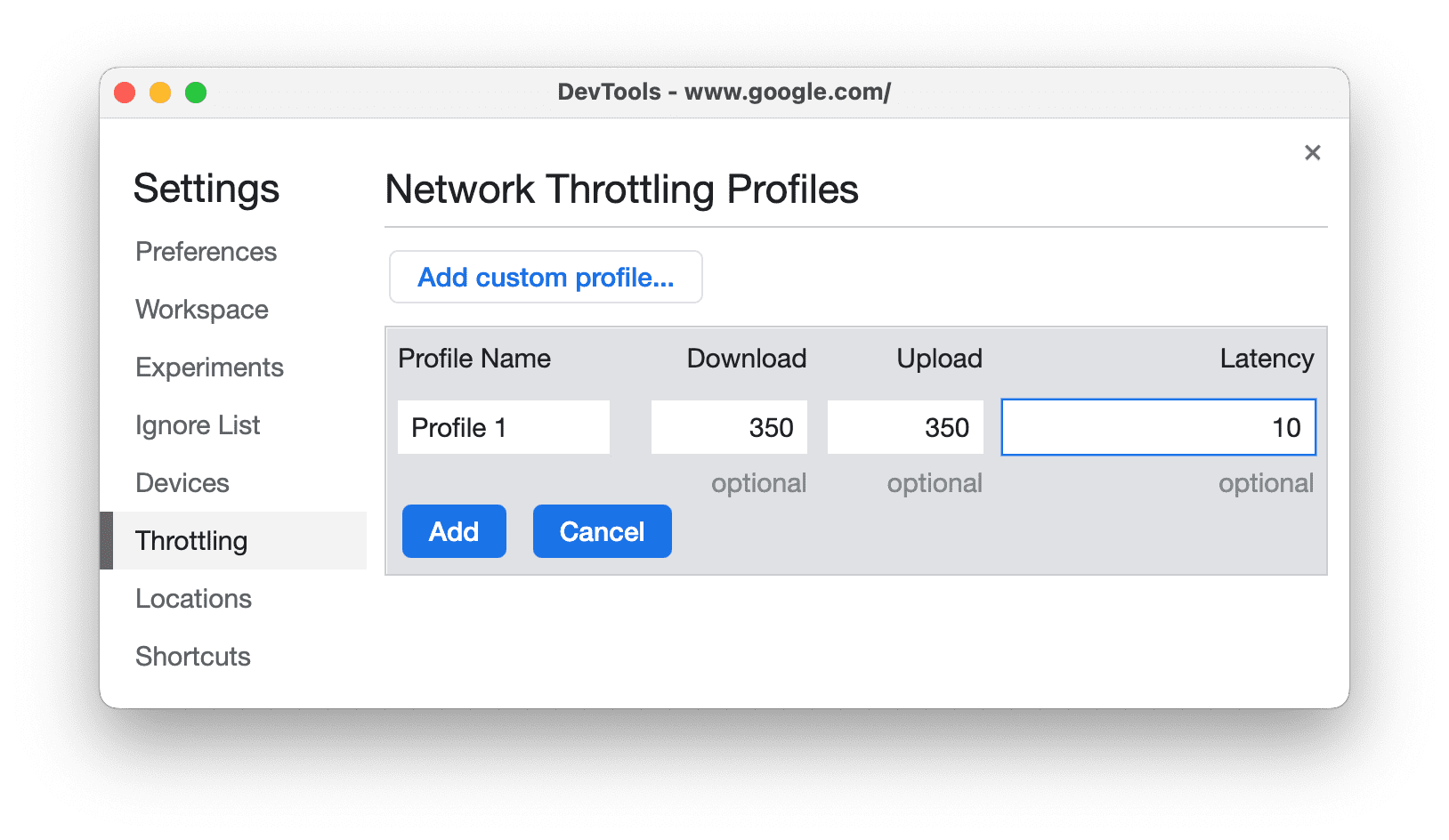

Il Throtting è una funzionalità avanzata per sviluppatori, presente in DevTools; tutti i browser nella sezione Network (Rete) hanno la possibilità di applicarla e ovviamente di default è disabilitata; a seconda del browser usato, sono possibili varie configurazioni, di connessione (3G veloce, 3G lento, ecc o anche - interessante - totalmente custom, come possiamo vedere nell'immagine che segue, tratta da developer.chrome.com) o anche misto rete+performance, limitazione alla CPU.

Quindi l'idea:💡analogamente al PPC Fake Traffic (Clic Fraud), almeno entro certi limiti, anche questa tecnica potrebbe essere potenzialmente sfruttata contro i competitors! Si parla sempre di fattibilità tecnica, non di questioni etiche.

A grandi linee, funziona così:

- dispositivo con IP, MAC Address, browser diverso (se vogliamo simulare utenti diversi, anche se non sempre indispensabile, è bene non usare sempre la stessa identica configurazione!)

- connessione diretta o traffico organico (poco cambia) al sito web target, se abbiamo impostato una forte limitazione di connessione, la pagina potrà anche impiegare 30+ secondi a caricarsi! Così come l'interazione con la pagina e reattività (dove clicchiamo, ecc), dipende da questi fattori

- lato Google, cosa abbiamo? Come detto all'inizio, i Core Web Vitals misurano l'esperienza utente e sono fattore di ranking (uno dei); il peso in percentuale che possono avere, dipende ovviamente dal singolo contesto, non è costante (diciamo però che analogamente alla pertinenza del contenuto e autorevolezza del sito, sono anch'essi uno dei parametri più importanti!); i Core Web Vitals rappresentano di fatto una media dei valori reali, se noi inviamo traffico molto lento (con interazione e UX che viene poi chiaramente etichettata come "scadente"), di fatto andiamo a cambiare il valore medio atteso

- esempio: se la pagina ha 10 visite (in un certo periodo di tempo) e caricamento medio di 3 secondi, noi inviamo un caricamento da 30 secondi, la nuova media diventa

LCP = (3*10+1*30)/(10+1) = 5,45 s, rispetto ai 3 secondi originari è quasi il doppio (+82%)

- analogamente al caso del PPC Fraud: l'esagerazione o la costanza di parametri (sempre lo stesso IP e dispositivo o troppo ravvicinati nel tempo e quindi poco credibili) verrà riconosciuta ed ignorata dagli algoritmi; simulare però utenti diversi, con connessioni diverse, di fatto va ad influire su quello che è il valore medio (tempo di caricamento della pagina, secondo questo esempio, il concetto si può comunque estendere anche al resto); un'analisi tramite Google PageSpeed Insights, che mostra (anche) i dati reali degli ultimi 28 giorni, oltre ai dati di laboratorio; dati reali significa suscettibili di eventuale attività creata artificialmente

- ultimo ma non meno importante: comprenderlo non significa usarlo! 😅 sono riflessioni di tipo tecnico, legate in generale allo studio della SEO

Ho quindi ideato una formula generale per quantificare come viene alterata la "nuova media", per la variabile oggetto di studio (ad esempio LCP, semplificando, il tempo di caricamento della pagina):

μ* = (μ + x1 * χ) / (1 + χ), dove:

- μ = media originaria (esempio 3 secondi)

- μ* = la nuova media che deriva in seguito all'attività

- x1 = il valore medio artificiosamente creato tramite Throtting (esempio 30 secondi)

- χ = il rapporto quantitativo dell'attività rispetto al totale, ovvero

χ = numero_simulazioni / numero_utenti_reali_originari