Dopo aver spiegato l'importanza di Screaming Frog, crawler che consente di analizzare siti web fornendo molte informazioni utili, vediamo ora le novità della versione 17 di Screaming Frog, appena rilasciata (fonte ufficiale: screamingfrog.co.uk)

- problemi/errori (issue tab): un'apposita sezione per avere un rapido riepilogo; da Bulk Export è possibile scaricare un file CSV contenente All - issue - warning - opportunity

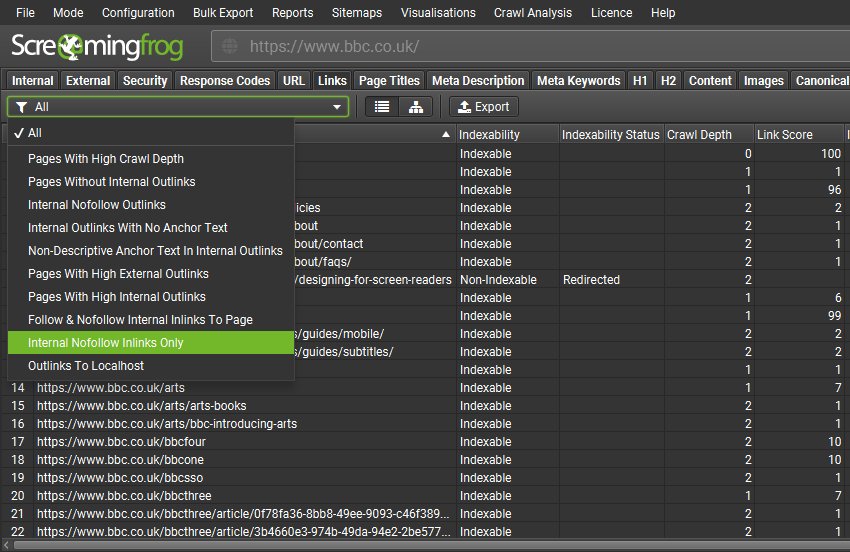

- sezioni aggiuntive per i Link: vedendo tutti i link interni, è possibile filtrare i risultati, ad esempio "visualizzare solo link di tipo nofollow"

- nuovi limiti (es URL totali), questo vale per la versione a pagamento, che non è limitata dal massimo di 500 URL

- proprietà multiple per l'integrazione con Google Search Console

- compatibilità con Apple Silicon (non solo processori Apple Intel) e distribuzioni Linux Red Hat / Fedora (file RPM); mi piacerebbe un giorno ci fosse compatibilità con Arch Linux (es. EndeavourOS)

- schede rimovibili e apribili come finestre esterne, in modo personalizzato (utile per avere sott'occhio qualcosa mentre stiamo facendo es. un altro crawling oppure abbiamo un'altra sezione aperta)

- altri bug fix

In definitiva questo è un aggiornamento importante e Screaming Frog si dimostra sempre un tool essenziale per chi si occupa di SEO e analisi di siti web.

Osservazione: è ben noto che la versione free di Screaming Frog consenta di analizzare un limite massimo di 500 URL; ogni sottodominio può essere scansionato in modo indipendente, quindi 500 URL per ognuno di essi. Tuttavia, possiamo fare una precisazione per quanto riguarda le directory. Di base, se nella scansione scriviamo sito.it/categoria non viene garantito che il crawling rimanga all'interno della directory (non si può specificare in questo modo), se sono presenti link di vario genere il tool li può eseguire; tuttavia, partendo da una determinata posizione piuttosto che la Homepage, è probabile che vengano scansionate molte pagine all'interno di quella directory. Eventualmente, se si vuole restare con la versione free, basta un po' di pazienza e si può ad esempio eseguire una scansione da una posizione, poi altre scansioni da posizioni diverse, esportate i vari dati (CSV) e unirli, alcuni URL sicuramente saranno in comune ma da ogni posizione è probabile che ne vengano analizzati di nuovi, mettendo assieme tutti i dati, si analizzano quindi oltre 500 URL diversi anche con la versione free.