Dopo aver letto notizie del tipo "Groq fa tremare ChatGPT di OpenaAI", "Groq può togliere la leadership a NVIDIA" ecc, clickbait ed esagerazioni a parte, mi sono chiesto: Groq, che azienda è? Dato che non la conoscevo, sono andato ad approfondire la cosa, vediamo un passo alla volta e direi che ne è valsa la pena!

Groq è una startup con sede a Mountain View (California), quindi zona Silicon Valley assieme a Google, ecc. L'azienda è stata fondata nel 2016 e attenzione a non confonderlo con Grok, chatbot di xAI, azienda fondata da Elon Musk (caratterizzata da un inizio molto lento, nessun modello rilasciato per oltre un anno e mezo, il vero salto di qualità lo ha poi fatto nel 2025 con Grok-3, quando si è allineata ai top del mercato).

Groq è nota per aver sviluppato un hardware proprietario tutto suo, con la sigla LPU, secondo un ragionamento interessante:

- i processori a livello costitutivo sono diventati estremamente complessi, funzionali per svolgere istruzioni sequenziali

- l'Intelligenza Artificiale (specialmente i chatbot che usiamo oggi) necessita di prendere decisioni in tempo rapido, con difficoltà nel raggiungere prestazioni soddisfacenti e contenere il consumo di energia

- dopo il fallimento nel tentare di aggiungere componenti e rendere ancora più complesse le CPU, è stata trovata una "soluzione parziale", quella delle GPU: eseguono molti calcoli in parallelo (maggiore produzione di calore, scarsa uniformità dello stesso e quindi possibilità di picchi, ecc), ma anche le GPU incontrano limiti soprattutto per quanto riguarda la rapidità di esecuzione

- l'azienda Groq ha quindi brevettato LPU (Language Process Unit) ovvero "unità di elaborazione linguistica", con un particolare tipo di chip, chiamato Tensor Streaming Processor (TSP): un modello linguistico come ChatGPT risulterebbe in questo modo fino a dieci volte più veloce se fatto girare su un'architettura LPU anziché GPU e il rapporto qualità-prezzo sarebbe addirittura cento volte migliore rispetto ai componenti forniti da NVIDIA (la crescita di NVIDIA, facendole raggiungere numeri stratosferici nell'ultimo anno, divenendo nella top 3 delle aziende più grandi al mondo per capitalizzazione, è dovuta principalmente al fatto che si è resa indispensabile vendendo chi ultracostosi, che finora è stata l'unica azienda in grado di fornire su larga scala e con quel livello di prestazioni e affidabilità); le LPU quindi sono componenti sviluppati in modo specifico per essere efficienti nelle operazioni che riguardano machine learning, algoritmi di Intelligenza Artificiale

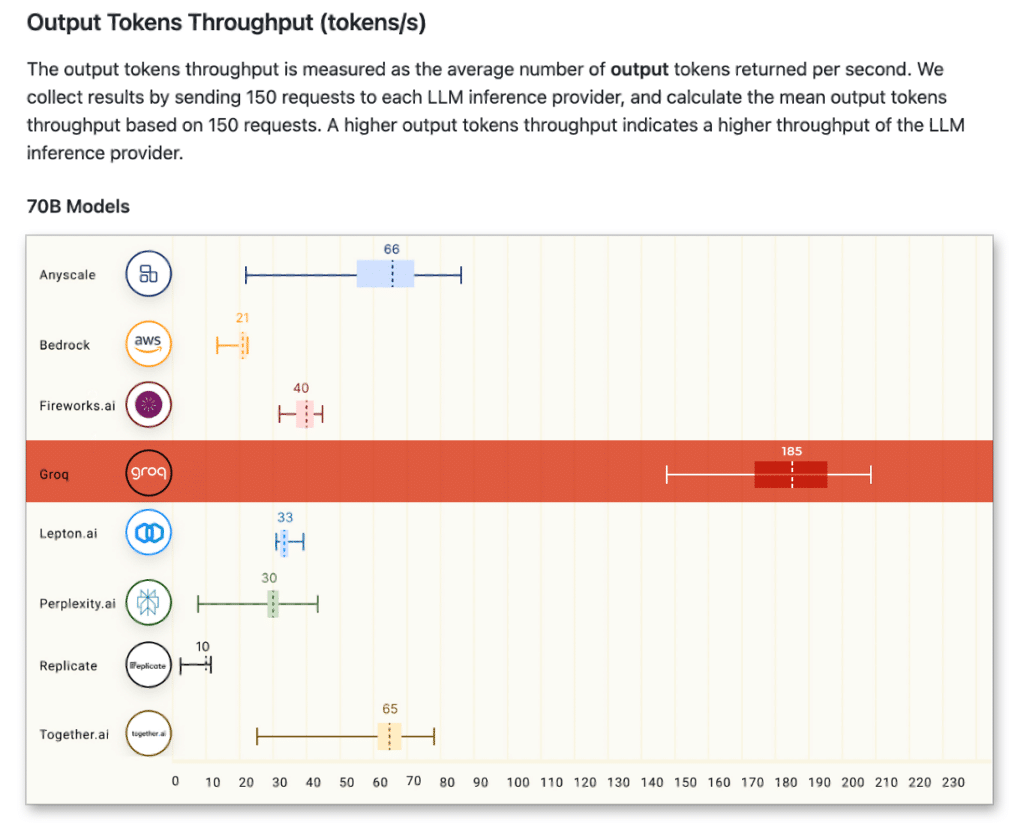

Dal sito ufficiale, un'immagine che mostra le prestazioni, netta leadership globale grazie a questa tecnologia proprietaria.

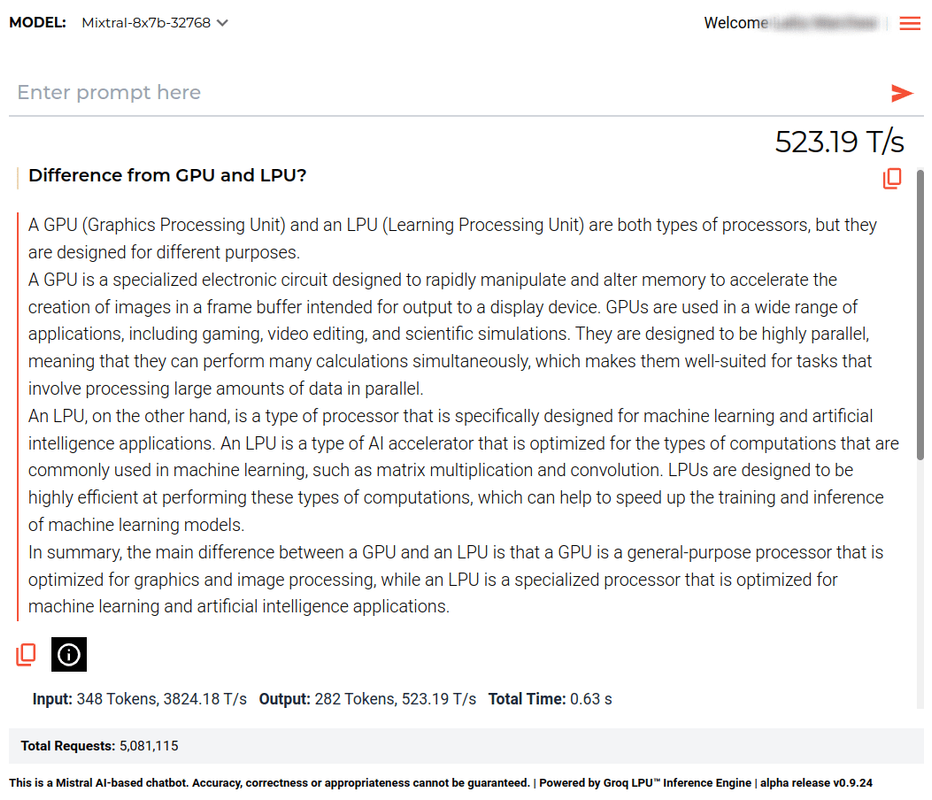

Groq ha sviluppato un proprio chatbot che possiamo testare liberamente, all'indirizzo groq.com, si effettua l'accesso con account Google, in modo analogo agli altri servizi. Possiamo scegliere fra due LLM, Llama2-70b-4096 (70 miliardi di parametri, 4096 token alla volta) e Mixtral-8x7b-32768 (8 blocchi da 7 miliardi di parametri ciascuno, 32768 token alla volta; vedi anche Mistral AI). In genere le risposte sono accurate e di buona qualità, contenendo bene il fenomeno delle "allucinazioni" (da un breve test, direi in linea con ChatGPT).

Dopo ogni risposta, viene fornito un box info, con "input token", "velocità input T/s", "output token", "velocità oputput T/s", "tempo totale". È in continua evoluzione e miglioramento, rispetto alla media dichiarata 185 T/s nel primo test ufficiale (il secondo migliore, Anyscale, con 66 T/s quindi nettamente distaccato), ora dal mio test come vediamo nell'immagine che segue, ha raggiunto 523,19 T/s oltre ad avermi fornito una risposta chiara e precisa (si consiglia di usare la lingua inglese).

Per concludere, divertente la provocazione ad Elon Musk, fatta da Groq (wow.groq.com):

Hey Elon, It’s Time To Cease & De-grok