Partiamo dal presupposto: tutto ciò che NON diciamo esplicitamente, il chatbot lo deve interpretare, stimare. L'effetto collaterale è una risposta fuori tema (per i nostri interessi) o, nella migliore delle ipotesi, piuttosto vaga e generica nel tentativo di "prendere dentro un po' tutto".

Quindi ora vediamo quanto sia importante, per massimizzare l'efficacia del risultato, considerare questi aspetti:

- specifica del ruolo: dire esplicitamente <<agisci come un esperto di filosofia/matematica>> aiuta il software a comprendere il nostro obiettivo, in un tema interdisciplinare, come ad esempio la logica, potremmo volere un approccio filosofico al tema oppure un approccio matematico rigoroso (se non lo diciamo, il software prova ad "indovinare" sulla base delle altre informazioni)

- specifica del livello richiesto e obiettivo: dire esplicitamente <<livello studente superiori / livello PhD>>, così come altre richieste <<salta l'introduzione teorica>>, <<per la pubblicazione su un forum / una sintesi generale solo per studio autodidatta>>, consente di indirizzare al meglio il risultato, senza dover interagire N-volte prima di ottenere il risultato desiderato

- bonus: qualunque specificazione aggiuntiva può essere molto utile, informazioni di ogni genere e anche nella struttura, design di risposta (<<vorrei una tabella comparativa>>) oppure allineamento cognitivo (approccio più pratico e diretto vs teorico e concettuale, astratto): più riusciamo ad essere precisi (ricordiamo che il "prompt engineering" è un'arte, o meglio, una scienza, o per certi versi anche entrambe le cose, in ogni caso talento+pratica consentono di ottenere risultati migliori, come in tutte le cose)

Fatta questa premessa, diciamo subito che un'architettura di tipo MoE (Mixture of Experts) (vedi LLM denso vs MoE) si presta meglio, poiché un LLM denso fa sempre uso di tutti i parametri e cerca un focus e prospettiva tipica di quell'ambito, ma non ha un "esperto" dedicato e rischia quindi di "mediare" senza una vera profondità (è invece molto più adatto a livello interdisciplinare). Un MoE invece è ovviamente più indicato per l'IA verticale, quindi per la specifica del ruolo e, nel caso del livello, richiesta di un livello avanzato (es. PhD, mentre per un livello di base la scelta del modello è poco rilevante) è proprio qui che un MoE eccelle, una domanda molto avanzata di matematica viene indirizzata all'esperto dedicato anziché venir elaborata da tutti i parametri per fornire una risposta "mediata". Questo oltre ad avere maggiore efficienza computazionale, poiché richiama un numero limitato di parametri per l'elaborazione e non tutti.

Vediamo quindi un esempio, caso di studio reale, con il chatbot Grok 4, che è un MoE avanzato (dichiarazioni dell'azienda, sempre da prendere con le pinze, <<Grok 4 is the most intelligent model in the world>>).

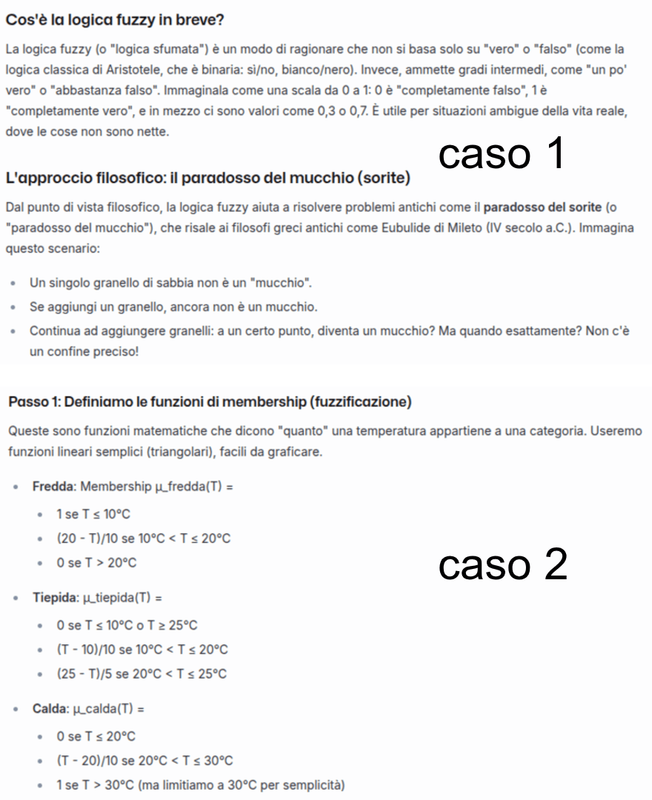

- Vorrei un caso di applicazione della logica fuzzy, con approccio di tipo filosofico, livello studente delle superiori

- Vorrei un caso di applicazione della logica fuzzy, con approccio di tipo matematico, livello studente delle superiori

- Vorrei un caso di applicazione della logica fuzzy, con approccio di tipo filosofico, livello avanzato PhD

- Vorrei un caso di applicazione della logica fuzzy, con approccio di tipo matematico, livello avanzato PhD

In breve, la logica fuzzy (o logica sfumata) è un caso differente, una possibile estensione rispetto alla logica booleana, classica. Le risposte per le quattro domande sono nettamente diverse, quindi il ruolo (esperto di matematica/filosofia) e il livello (studente delle superiori / avanzato PhD) è stato determinante. Vediamo gli screenshot di parte delle discussioni.