Oggi stiamo assistendo ad una crescita forte e continua dell'Intelligenza Artificiale. Enormi investimenti, per poter sviluppare modelli di IA generativa sempre migliori. Poi arriva la cinese DeepSeek che ha decisamente sconvolto le carte in tavola, gli USA con investimenti miliardari credevano di avere leadership incontrastata mentre DeepSeek è arrivata al 90% e più delle prestazioni (confronto con i top, ChatGPT, Google Gemini nelle ultime versioni), ad un costo di addestramento minore di 1/10. Quindi un risultato impressionante in termini di efficienza, che dopo lo sconvolgimento iniziale, ha fatto riflettere il mondo su due concetti, fondamentali per il futuro, vediamone uno alla volta.

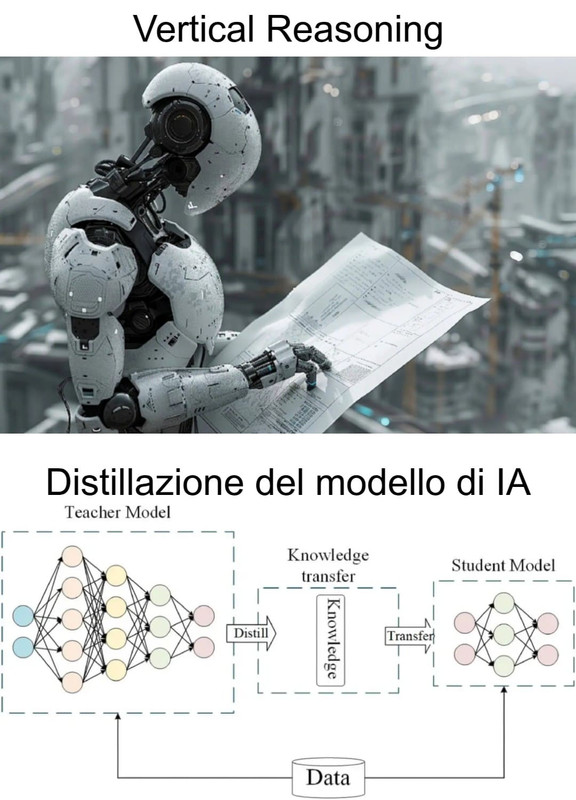

Ragionamento Verticale (Vertical Reasoning)

In breve, anche noi non possiamo essere sia medici sia avvocati sia ingegneri, quindi vista la complessità che aumenta esponenzialmente, quando si tratta di problemi coomplessi e non una banale sintesi, anziché incorrere nel rischio di allucinazioni, imprecisioni (inaccettabili dal punto di vista professionale!), occorre quindi addestrare un modello sull'ambito specifico, non dati generali del web ma forniti ad.hoc (manuali tecnici, schemi di impianti, ecc) quindi non la ricerca di una correlazione statistica basata sulle parole (che potrebbe portare a gravi errori o una risposta troppo vaga e inutile) ma una comprensione delle relazioni causali e quindi alla domanda "perché si è rotto questo pezzo, come lo aggiusto?", la specializzazione del modello riesce ad essere realmente utile

Distillazione della Conoscenza (Knowledge Distillation)

Un po' come il concetto di produttività marginale, quando è stato rilasciato GPT-4, con 1760 miliardi di parametri, lo scopo era creare sempre il modello migliore, ad ogni costo e quindi penalizzando fortemente l'efficienza; poi sono stati creati modelli dai risultati del tutto rispettabili, Mistral 7B (vedi Ollama), anche modelli italiani da pochi miliardi di parametri (vedi Indigo.ai); significa che aumentando il numero di parametri, si incorre in un'enorme inefficienza, consumo di risorse, per avere solo piccoli miglioramenti (la qualità dei dati di partenza e come viene addestrato il modello, sui vari parametri, diventa quindi un fattore cruciale, anziché "sprecare" l'uso di parametri inutilmente); la distillazione della conoscenza è un metodo particolare che ha lo scopo di "trasferire la conoscenza" da un modello grande, più complesso (modello insegnante) al più piccolo e semplice (modello studente); il modello studente non solo apprende dall'insegnante la risposta corretta (più verosimile), ma l'intera distribuzione di probabilità (ad esempio un'immagine 90% cane, 8% volpe, 2% lupo, il modello studente apprende la distribuzione e non solo il risultato identificato come più probabile); il vantaggio è che, se ben addestrato, il modello studente che è molto più piccolo e leggero del modello insegnante, può arrivare a prestazioni simili (da qui il fatto che un modello da 1760 parametri è sicuramente migliore di uno da 7 o 14 miliardi di parametri, ma non di certo 100-200 volte migliore! Per riprendere quanto detto all'inizio, sull'incremento marginale, efficienza decrescente all'aumentare delle dimensioni)

Conclusioni

Per il futuro, questi due approcci sono sicuramente indispensabili. Non possiamo pensare di espandere il database dei modelli all'infinito, così come le dimensioni in termini di parametri ed energia richiesta per il funzionamento, altrimenti tutto il sistema andrebbe presto al collasso. La specializzazione settoriale (ragionamento verticale) e la distillazione della conoscenza (trasferire il "sapere", da un modello grande ad uno piccolo, permettendogli di raggiungere comunque risultati buoni), sono sempre più importanti. La Cina a fine gennaio ha infatti dimostrato al mondo che c'è ancora molto margine di miglioramento riguardo all'efficienza, rilasciando un modello dalle prestazioni analoghe ai top presenti sul mercato, ma con un costo enormemente ridotto e questo fa riflettere.

Infine un'immagine che raffigura queste due diverse tecniche, tratta da ai4business.it.